Последнюю Версию Драйверов Для Nvidia Geforce 560

Скачать последний драйвер geforce, nvidia. Также в последнюю версию. Nvidia geforce 840m.

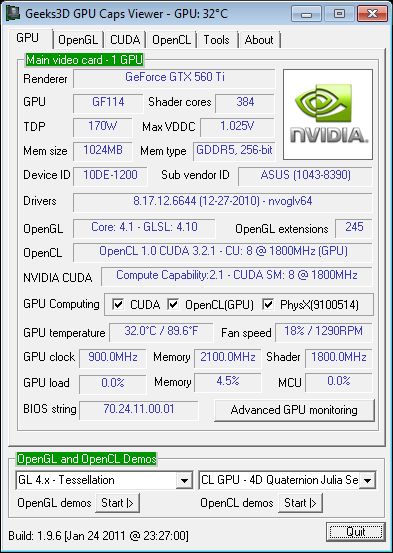

В общем у меня видеокарта ASUS GTX 560 Ti (448 Cores). Многие наверное в курсе особенностей этой модели, но на всякий случай перечислю ещё раз, с целью акцентировать нижеописанный вопрос: - видюха 320-разрядная - 3-слотовая с огромным радиатором, с особо крутым охлаждением за счёт этого - 1280 МБ Так вот к чему я клоню. Играю я на разрешении 1920х1080 на полностью максимальных настройках.

BETA Драйверы И Архив

Недавно решил измерить температуру Everest'ом и увидел что видюха разогревается до 70 градусов цельсия. ВОПРОС: Нормально ли, что у ТАКОЙ видюхи при такой (на мой взгляд слабой) нагрузке, как Диабла (даже на максималке) такая высокая (как мне кажется) температура? По мне так она должна кушать Диаблу чуть ли в пассивном режиме.

Нормально ли вообще что чипак греется до 70 градусов? А какая температура страшная для видюхи?

У моего товарища на ноутбуке видюха грелась до 95 градусов, но то было на ноутбуке и это отдеьная песня. Что-то ещё я такое слышал, что при температуре 100 градусов чип видеокарты начинает 'деградировать'. Хз что это значит или я неправильно понял. В общем немного обеспокоен температурой видюхи, разъясните кто разбирается что да как. Не стал ставить ASUS Smart Doctor. После обновления дров с официального сайт nVidia игра больше не вылетала и не глючила. Похоже дело было именно в них в обновлении драйвера.

До этого была версия в районе 301. Сейчас то уже 306.97, почти 307. Более того в описании последней версии драйвера нашёл пункт: Обновление других профилей В Панель управления NVIDIA добавлена поддержка сглаживания для Diablo III Собственно сам драйвер если что Может это и было проблемой.

Как-то некорректно работало например сглаживание у меня, которое как раз включено в игре. ASUS Smart Doctor, позволяет вручную настроить температурные пороги, это позволяет понимать как реагирует видеокарта на поднятие температуры. Иначе ее кулер работает не понятно как.

Это справедливо для видях ASUS начиная с 250й серии (и выше) помогает во всех играх и оптимизирует работу кулеров под нагрузку и не гоняет его впустую. Если поставить Smart Doctor то перегрева не будет: Недавно решил измерить температуру Everest'ом и увидел что видюха разогревается до 70 градусов цельсия. Дрова не влияют на работу кулеров. И если будет перегрев то можно попалить видяху. Системные требования DIII по видюхе - 260-я.

А это весьма неслабая видюха до сих пор. Так что DIII очень даже требовательная игра. И графика здесь далеко не прошлый век. Просто у людей создаётся ощущение, что графика так себе из-за статичного положения камеры.

А на самом деле многие современнейшие 3D-технологии задействованы по полной программе. Шейдеры, например, тут просто отличные. У 560-ой Ti c 448-мью CUDA-ядрами максимальный безопасный нагрев - 97 градусов Цельсия. Если у вас 70 при жаре в комнате, то вы имеете весьма большой запас по нагреву.

Нечего даже и переживать.

14 июня 2011 Знакомьтесь: GeForce GTX 560 Компании nVidia и AMD делают всё возможное для того, чтобы удостовериться в том, что у них есть что предложить в качестве альтернативы на любой из товаров конкурента. Ни одна видеокарта ещё не становилась доминирующим продуктом в той или иной ценовой группе надолго. Приведём пример: недавно nVidia выпустила как достойного соперника модели Radeon HD 5770/6770, а AMD, в свою очередь, представила видеокарту, которая может составить конкуренцию GeForce GTX 460 768 Мбайт от nVidia. NVidia нанесла компании-сопернице ещё один удар: она выпустила GeForce GTX 560. Обратите внимание на отсутствие суффикса 'Ti'.

Скачать

Видеокарта конкурировала с моделью Radeon HD 6950 1 Гбайт от AMD. Таким образом, этот продукт предназначен для 'борьбы' с чуть менее дорогой видеокартой Radeon HD 6870, которую можно купить в интернет-магазинах по цене около $200.

Но каким образом компания nVidia превратила модель в GeForce GTX 560? Да, здесь потребовалось больше действий, чем просто взять и убрать суффикс. Это как если бы чип GF114 внезапно получил взбучку от безобидной поролоновой игрушки. Другими словами, nVidia выключает потоковый мультипроцессор.

Получается, что GeForce GTX 560 работает, задействуя семь из восьми потоковых мультипроцессоров у GF114. У каждого работающего SM есть 48 потоковых ядер, четыре блока диспетчеризации и восемь текстурных блоков.

Все четыре 64-битных раздела ROP функционируют и каждый из них способен обрабатывать восемь 32-битных целочисленных пикселя за тактовый цикл. В результате у модели GeForce GTX 560 насчитывается 336 потоковых ядер, 56 текстурных блоков и 32 конвейера растровых операций (Raster operation - ROP) c 256-битным интерфейсом памяти. Если данные спецификации звучат для вас знакомо, то это потому, что они в точности повторяют характеристики GeForce GTX 460 1 Гбайт от nVidia. Оно и понятно: в конце концов, графический процессор GF114 с функциональной точки зрения идентичен модели GF104. Просто его доработали, чтобы он мог обеспечивать более высокие показатели тактовой частоты при меньшем потреблении энергии. Учитывая всё вышенаписанное вы можете предположить, что видеокарта GeForce GTX 560 нацелилась на то, чтобы заменить модель GeForce GTX 460.

Но есть ещё одна переменная, которую необходимо принимать в расчёт: тактовая частота. У эталонной видеокарты GeForce GTX 460 ядро функционировало при 675 МГц, а память GDDR5 требовала 900 МГц.

Но модель GeForce GTX 560 работает при частоте 810 МГц для ядра и 1002 МГц для памяти — это намного ближе к уровню (822/1022 МГц для ядра и памяти, соответственно). Все мы помним, что после разгона производительность GeForce GTX 460 неплохо возрастала. Именно по этой причине мы ожидаем, что GeForce GTX 560 с лёгкостью составит достойную конкуренцию модели Radeon HD 6870 от AMD. Что касается конкурирующих товаров, давайте рассмотрим другие варианты по аналогичным ценам.